本文对闲聊最新通报进行了深入解读,分析了AI对话模型的监管政策演变、伦理挑战和技术难题。文章指出,未来闲聊技术将朝着更加个性化、多模态交互、与其他AI技术融合的方向发展,同时需要建立更严格的伦理规范和监管体系,以确保AI技术健康发展,避免潜在风险。文章也提到了闲聊模型的伦理挑战和数据安全问题,强调了算法公平性和可解释性的重要性。

AI对话模型监管政策的演变

近年来,随着人工智能技术的快速发展,AI对话模型,例如基于大型语言模型的聊天机器人,越来越受到关注。这些模型具备强大的自然语言处理能力,可以与用户进行流畅的对话,并在诸多领域展现出巨大的应用潜力。

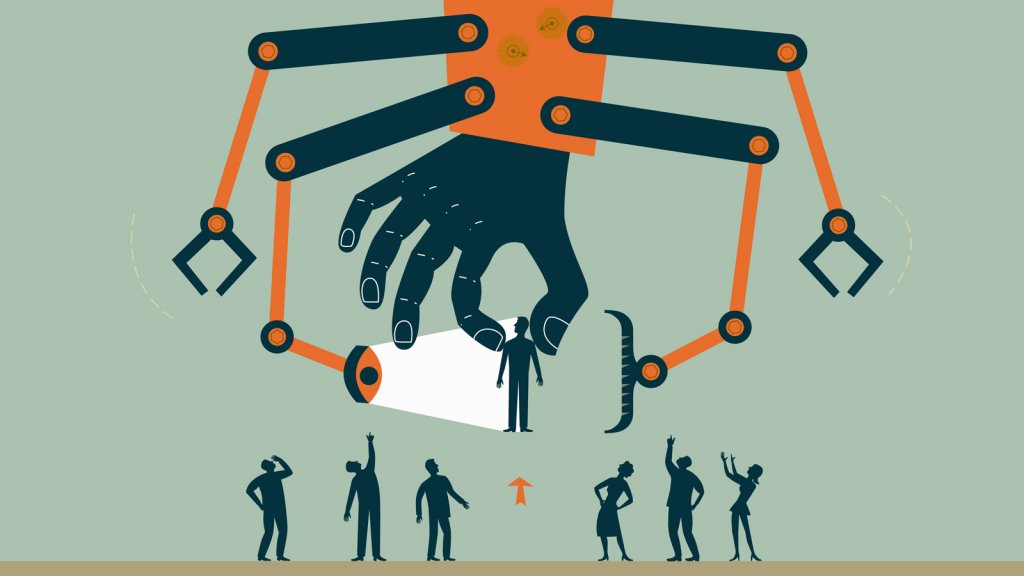

然而,AI对话模型也带来了一些挑战,例如生成虚假信息、传播有害内容以及侵犯用户隐私等问题。因此,各国政府和监管机构纷纷出台相关政策,以规范AI对话模型的开发和应用。

例如,某些国家已出台了针对深度伪造技术的监管措施,旨在防止恶意使用AI技术生成虚假视频或音频以进行欺诈或诽谤。此外,一些行业协会也制定了自律规范,引导企业在AI开发和应用中遵守伦理规范。

从历史来看,人工智能的监管历程经历了从宽松到严格的过程。早期,由于技术发展相对缓慢,监管力度相对较弱。但随着技术的成熟和应用范围的扩大,监管力度逐渐加强。

展望未来,AI对话模型监管政策将继续完善,更加注重技术的伦理和社会责任。这将需要政府、企业和社会各界共同努力,建立一套完善的监管体系,确保AI技术健康发展。

闲聊模型的伦理挑战与社会影响

闲聊模型作为一种新兴技术,其伦理挑战和社会影响不容忽视。一方面,闲聊模型可能被用于生成虚假信息,误导公众,甚至造成社会恐慌。另一方面,闲聊模型也可能被用于歧视或偏见,加剧社会不平等。

例如,一些研究表明,一些大型语言模型存在性别和种族偏见,在回答相关问题时会体现出对特定群体的不利倾向。这需要开发人员在模型训练过程中更加注重数据平衡和算法公平性,努力减轻模型中的偏见。

此外,闲聊模型的数据安全也备受关注。由于模型训练需要大量数据,这其中可能包含用户的个人隐私信息。如何保障用户数据的安全性和隐私性,是闲聊模型应用过程中必须解决的问题。

为了应对这些挑战,我们需要加强对闲聊模型的伦理监管,制定相关标准和规范,并开展相关的伦理教育,提升公众对AI技术的认知和理解。

闲聊最新通报中提到的技术难题与应对策略

最新的闲聊通报中,可能重点关注了AI对话模型在技术层面面临的诸多难题,例如模型的可解释性、鲁棒性以及可控性。模型的可解释性是指我们能否理解模型如何得出某个结论,这对于保证模型的公平性和可信度至关重要。

例如,一个医疗诊断模型如果无法解释其诊断结果,那么医生就很难判断其可靠性,也就难以将其应用于临床实践。

模型的鲁棒性是指模型在面对噪声或干扰时能否保持稳定的性能,而可控性是指模型能否按照预期的方式运行,避免出现意外行为。

针对这些技术难题,我们需要不断改进模型的算法和架构,探索新的技术方法,例如可解释AI (XAI) 技术,以提高模型的可解释性、鲁棒性和可控性。

闲聊技术的未来发展趋势及展望

- 更加个性化和定制化的对话体验

- 多模态交互的融合与发展

- 与其他AI技术的融合与应用

- 对不同行业的赋能与创新

- 更严格的伦理规范和监管体系

鄂ICP备15020274号-1

鄂ICP备15020274号-1